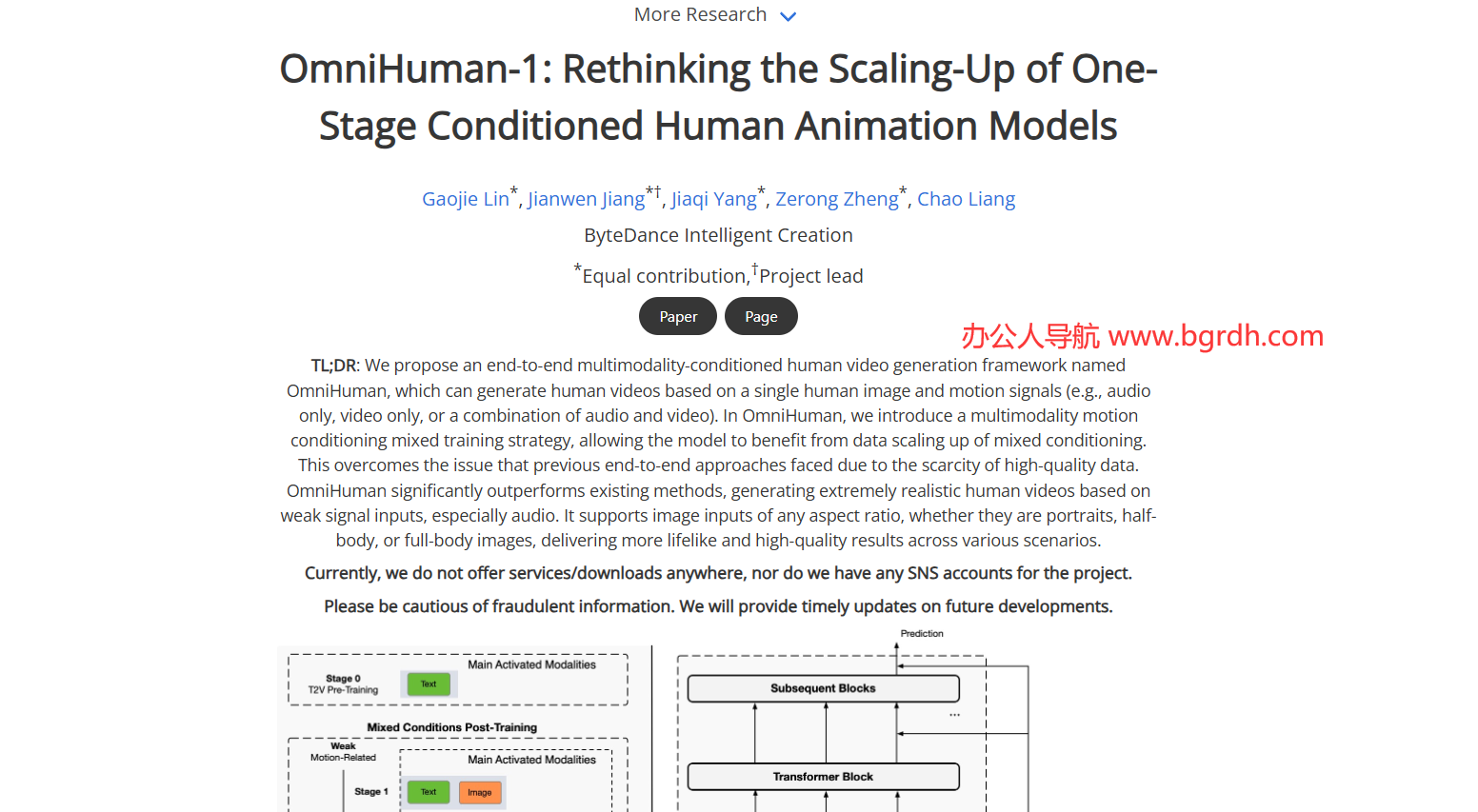

OmniHuman 是字節跳動推出的端到端多模態 AI 數字人生成框架。它能夠僅憑 一張靜態人物照片 與 音頻(語音、音樂)?,自動生成 逼真的全身視頻,實現人物說話、唱歌、演奏樂器、手勢交互等多種動作與表情同步。

OmniHuman官網入口網址:https://omnihuman-lab.github.io/

關鍵特性

- 多模態條件驅動:支持圖像、音頻、姿態等多種信號作為驅動條件,實現音頻?動作?口型的高精度同步。

- 基于 Diffusion?Transformer(DiT)架構:將擴散模型與 Transformer 結合,采用 混合條件訓練策略,在大規模多模態數據上進行端到端學習,突破了傳統數字人模型對單一訓練信息的依賴。

- 全條件訓練:通過“全條件”方式讓模型從更廣泛的數據中學習,提升了對不同風格(真人、動漫、3D 卡通)和不同圖像比例(肖像、半身、全身)的適配能力。

- 高質量輸出:生成的視頻在細節、光照、紋理上保持一致,能夠精準捕捉音頻情感并對應相應的肢體動作和表情,支持 15 秒一鍵生成,已在教育、影視、虛擬偶像等商業場景落地。

- 開放 API(即夢AI 平臺)?:通過即夢AI 提供的 API,用戶只需上傳圖片和音頻,即可調用 OmniHuman 完成視頻生成,降低了創作門檻。

技術亮點

- 多模態運動條件混合訓練:在訓練階段同時引入文本、音頻、姿態等多種驅動信號,提升模型對弱信號(如僅音頻)的生成質量。

- 支持任意寬高比輸入:模型能夠處理不同尺寸的圖像,保持原有運動風格,適用于肖像、半身、全身等多種場景。

- 跨模態生成能力:除了音頻驅動,還可接受姿態或視頻驅動,實現更靈活的動畫創作。

應用場景

- 短視頻創作:快速生成帶口型同步的宣傳或帶貨視頻。

- 虛擬主播/數字人:用于直播、教育培訓中的虛擬形象。

- 影視特效:為角色動畫提供高效的動作與表情合成。

- 游戲與動漫:將靜態角色圖像轉化為動態演繹,提升互動體驗。

OmniHuman 的應用場景能夠顯著降低制作成本、提升創作效率。OmniHuman 代表了 AI 數字人技術從“上半身動畫”向“全身高保真視頻”邁進的重要一步。

相關導航

暫無評論...